Ich dachte nicht, dass ich 2026 noch so einen Blog schreibe… Im Dezember habe ich zwei Beratungen durchgeführt, in welchen Kunden Copilot und Power Automate einsetzen wollten, um Dokumentvorlagen mit Inhalten zu füllen. Diese sollten dann in SharePoint abgelegt werden. Dies ist sicher mit den Tools oben möglich, aber der Aufwand dafür ist hoch. Einfacher ist es, Überraschung, mit SharePoint. Dieser Blog beschreibt, wie Sie die genannte Anforderung damit einfach und schnell umsetzen. Bevor ich aber ans Erklären gehe, muss ich noch ein paar Begriffe erläutern.

Um das Problem zu lösen, müssen wir SharePoint Inhaltstypen, Dokumentenvorlagen und Metadaten benutzen. Dokumentenvorlagen und Inhaltstypen bilden in SharePoint die Grundlage einer strukturierten, skalierbaren und einheitlichen Dokumentenverwaltung. Sie sorgen dafür, dass Dokumente konsistent erstellt, mit Metadaten versehen und in wiederholbaren Prozessen verwendet werden können.

Was sind Inhaltstypen?

Inhaltstypen (engl. Contenttyps) definieren, welche Art von Informationen ein Dokument oder Element enthält, wie es klassifiziert wird und welche Prozesse damit verbunden sind. Es sind Templates für Datenstrukturen. Sie legen fest, welche Daten wie erfasst werden (z. B. Metadaten, Workflows, Richtlinien), sind ein Grundkonzept von SharePoint und hierarchisch organisiert. Erst durch sie wird Wissensmanagement und Dokumentenverwaltung überhaupt erst sinnvoll möglich. Alle Informationen in SharePoint, egal welche Liste, basieren auf Inhaltstypen. Jeder Inhaltstyp kann dabei seine eigene Metadatenfelder (Websitespalten) und Vorlage haben.

Sie ermöglichen einheitliche Strukturen statt unkontrollierter Ordnerhierarchien und saubere Such- und Filtermöglichkeiten. Sie sind die Grundlage für Automatisierung (Workflows, Retention, Purview) und bieten „Eine Version der Wahrheit“ statt duplizierter Dateien.

Jeder Dokumenten Inhaltstyp besitzt eine Dokumentenvorlage– also zum Beispiel eine Word‑Vorlage für ein Vertrag, eine PowerPoint‑Vorlage für eine Projektpräsentation oder eine Excel‑Vorlage für Kostenkalkulation. Wenn Benutzer in einer Bibliothek ein neues Dokument erstellen, wählt SharePoint automatisch die passende Vorlage – inklusive aller vordefinierten Metadatenfelder, basierend auf den ausgewählten Inhaltstyp.

Vorlagen und Metadaten verbinden

An erste Stelle steht die Definition der Inhaltstypen samt deren Metadaten. Welche Dokumenttypen habe ich? Welche Verträge, Angebote, Aufträge und Rechnungen? Welche Metadaten, also SharePoint Spalten benötige ich für die einzelnen Inhaltstypen? All das läßt sich einfach in einer Exceltabelle erfassen. Machen Sie das unbedingt, so etwas mal nebenbei zu machen, geht immer schief.

Wenn dies erledigt ist, brauchen wir Dokumente, welche als Vorlage verwendet werden können. In meinem Beispiel werde ich die Vorlage für einen Vertrag verwalten, wobei natürlich dies analog auf andere Inhaltstypen übertragbar ist. Die Vorlage hat den Namen Vorlage_Vertrag.docx und wird in einer SharePoint Dokumentbibliothek mit dem Name Templates verwaltet. Damit können Sie die SharePoint Versionierung und auch die Möglichkeiten für filtern/sortieren nutzen, welche SharePoint Bibliotheken zur Verfügung stellen. Wichtig ist, dass alle Benutzer, welche damit arbeiten sollen, auf die Bibliothek Templates Leserechte benötigen.

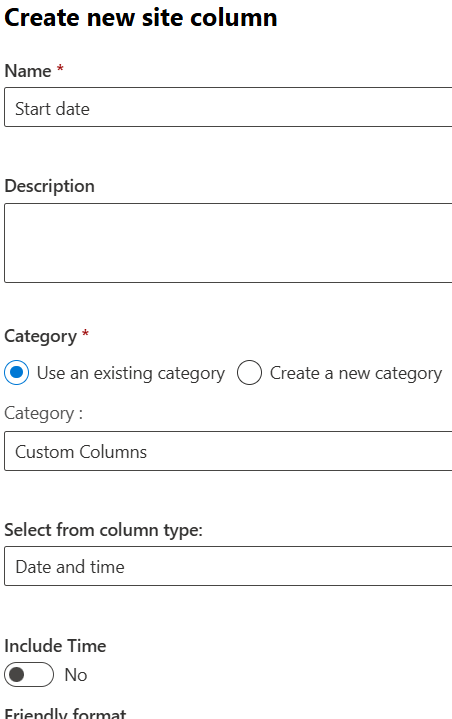

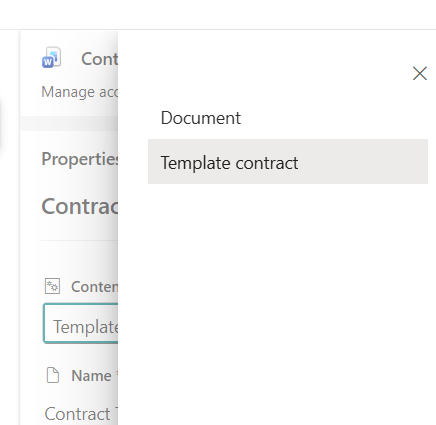

Ebenso gibt es einen Inhaltstyp Template contract, welche vom Inhaltstyp Dokument erbt. Diesen Inhaltstypen wird dann die Vorlage zugewiesen. Der Inhaltstyp Template contract enthält die folgenden Metadaten, wobei auch noch weitere möglich sind.

| Metadatum | Typ und Beschreibung |

| Start date | Datum. Startdatum, ab dem der Vertrag gilt. |

| End date | Datum. Enddatum, bis zu dem der Vertrag gilt. |

Die Bibliothek für die Verträge heißt Verträge und ist in der Site schon erstellt wurden.

Inhaltstyp erstellen und einer Bibliothek zuweisen

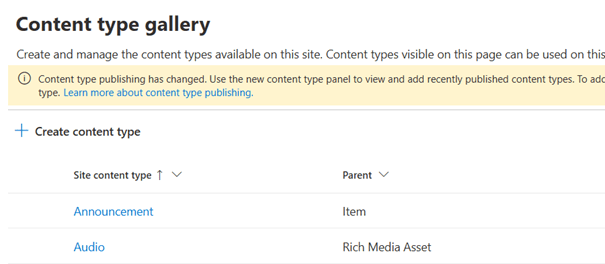

Für allen folgenden Einstellungen sollten Sie Site Administrator oder Sitebesitzer sein. Klicken Sie oben rechts auf das Zahnrad und dann auf Site Information > View all site settings. Dort im Abschnitt Web Designer Galleries auf Site content types.

Klicken Sie dort auf Create content type. Als erstes müssen Sie den neuen Inhaltstyp einen Namen geben. Da es in meinem Fall um eine Vorlage für einen Vertrag geht, nenne ich meinen neuen Inhaltstyp Template contract. Wichtig ist der übergeordnete Inhaltstyp. Damit legen Sie fest, welcher bisher vorhandene Inhaltstyp auf den neuen Inhaltstyp vererbt wird. Wir wählen den Inhaltstyp Document aus der Kategorie Document Content Types. Nach dem Erstellen können Sie über Add sites column > Create new site column die oben erwähnten Spalten dem Inhaltstyp hinzugefügen.

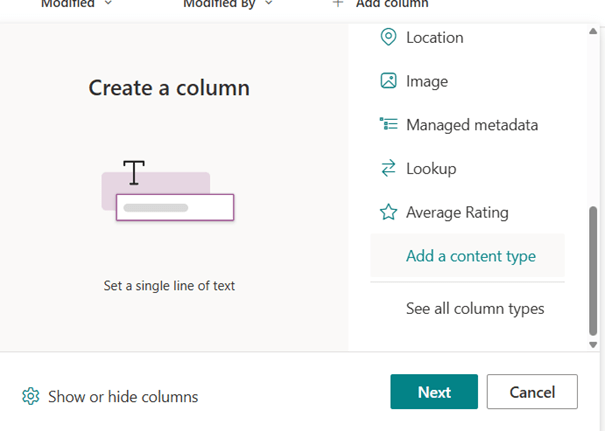

Gehen Sie jetzt in die Bibliothek Verträge. Klicken Sie dort auf + Add column, scrollen ganz nach unten und klicken auf Add a content type und Next.

Wählen Sie im Dropdown den eben erstellen Inhaltstyp aus. Laden Sie jetzt ein Dokument in die Bibliothek hoch, welches schon die Vorlage für den Vertrag enthält. Über die Metadaten des Dokumentes, Spalte Content type, stellen Sie ein, dass dieses Dokument vom Typ Template Contract ist.

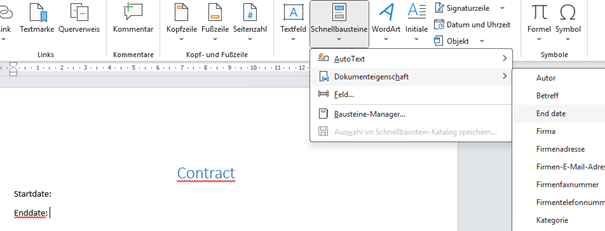

Öffnen Sie jetzt das hochgeladene Dokument in Word Client und fügen Sie die Metadaten aus der Bibliothek in das Dokument ein. Diese werden dann zur Laufzeit für jedes Dokument ersetzt mit dem Wert, der in der SharePoint Spalte steht. Um die Werte einzufügen, gehen Sie in Word auf Insert > Quick Parts > document property > Field name.

Wenn Sie fertig sind, speichern Sie das Dokument und laden es in die Bibliothek Templates auf der Website hoch. Kopieren Sie anschließend den Link des Dokumentes aus dem Detailpane. Er befindet sich ganz unten, die Eigenschaft Pfad. Kopieren Sie nicht den Link aus dem Kontextmenü, dieser funktioniert nicht.

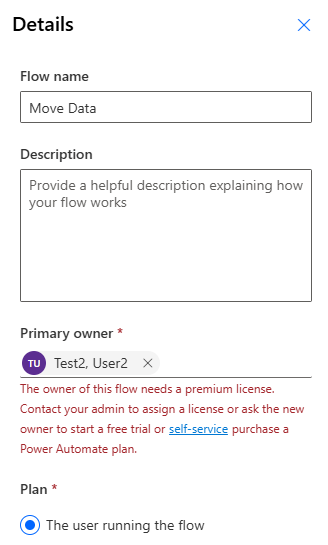

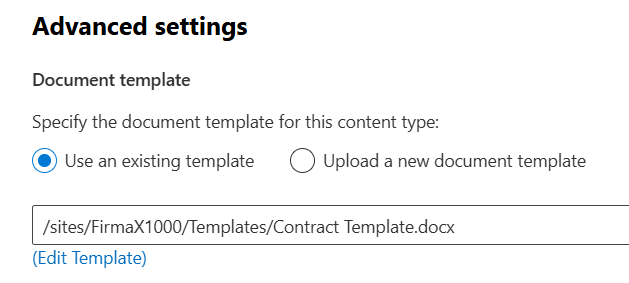

Gehen Sie zum Abschluss noch einmal in die Site settings und in die Inhaltstypen. Suchen Sie den neu erstellen Inhaltstyp und öffnen diesen. Klicken Sie auf Advanced settings. Hier können Sie unter Document template den eben kopierten Link einfügen.

Wenn Sie jetzt speichern und wieder in die Bibliothek Verträge gehen, können Sie aus dem Menü + Create or upload direkt einen neuen Vertrag erstellen. Wenn Sie in die SharePoint Spalten Werte eintragen, und diese Spalten mit der Vorlage verbunden sind, werden diese auch sofort in dem Dokument angezeigt. Diese Spalten können zum Beispiel mit Power Automate befüllt werden. Per Flow einen neuen Datensatz von Typ Vertrag anlegen, Spalten per Flow füllen, fertig.

Dies war jetzt nur eine Übersicht. Wenn Sie mehr dazu wissen möchten, sprechen Sie mich an.